Concept Art made by KI

Re: Concept Art made by KI

Genau das meinte ich auch.

Es läuft drauf hinaus:

Make cool graphic X, with Seed Y.

Zack!

Es läuft drauf hinaus:

Make cool graphic X, with Seed Y.

Zack!

Re: Concept Art made by KI

Es läuft ja meist darauf hinaus, dass an Content "gut" eben zur Massenware und bald uninteressant wird, und irgendwer dann "besser" entwickelt, um wiederum etwas mehr aus der Masse herauszustechen.

CG in Kinofilmen z.B.: Zu Terminator-2-Zeiten war man sogar noch auf Making-Ofs scharf. Sowas kann heute jeder PC in Echtzeit zuhause, das reißt niemanden mehr vom Hocker. Deswegen sind wir CG-Technisch aber noch lange nicht abgestumpft, im Gegenteil, die Ansprüche sind gestiegen. (Heißt nicht, dass diese Erwartungen stets erfüllt werden)

Zur AI- und Gamedev-Geschichte sollte noch erwähnt werden, es ist erstmal nur ein weiteres Tool im Workflow. Es wird nicht den Workflow an sich ablösen. Aber ihn evtl. ändern und in manchen Punkten abkürzen. An anderen Stellen stellt es sich vielleicht sogar kontraproduktiv heraus.

Fernsehen wollte nie Radio ablösen und wäre für Autofahrer auch fatal. VR-Computerspiele nie die Realität. Es wäre Quatsch, da jetzt auch bei KI auf Ganz-oder-gar-nicht zu spekulieren.

CG in Kinofilmen z.B.: Zu Terminator-2-Zeiten war man sogar noch auf Making-Ofs scharf. Sowas kann heute jeder PC in Echtzeit zuhause, das reißt niemanden mehr vom Hocker. Deswegen sind wir CG-Technisch aber noch lange nicht abgestumpft, im Gegenteil, die Ansprüche sind gestiegen. (Heißt nicht, dass diese Erwartungen stets erfüllt werden)

Zur AI- und Gamedev-Geschichte sollte noch erwähnt werden, es ist erstmal nur ein weiteres Tool im Workflow. Es wird nicht den Workflow an sich ablösen. Aber ihn evtl. ändern und in manchen Punkten abkürzen. An anderen Stellen stellt es sich vielleicht sogar kontraproduktiv heraus.

Fernsehen wollte nie Radio ablösen und wäre für Autofahrer auch fatal. VR-Computerspiele nie die Realität. Es wäre Quatsch, da jetzt auch bei KI auf Ganz-oder-gar-nicht zu spekulieren.

Re: Concept Art made by KI

Wobei ich sagen muss, dass ich schon relativ lange nicht mehr diesen Wow-Effekt bei Filmen erlebt habe. Dieses "Wie haben die das bloß gemacht?". Ich hab so viele gute Effekte gesehen, dass das jetzt die Normalität ist, eigentlich störe ich mich nur noch an schlechten Effekten, freue mich aber nicht mehr über gute. Bissle schade eigentlich. Es gab da nur ein paar Ausnahmen, beispielsweise diese Spiegelszenen aus irgendeinem Docter Strange Film oder dieser Star Wars Film mit dem Sand der rote Spuren zog und dem Raumschiff in der Kristallhöhle in der nächsten Szene. Wobei ich da auch glaube ich tatsächlich eher den künstlerischen Aspekt beeindruckend fand, als die technischen.joeydee hat geschrieben: ↑12.01.2023, 13:29 CG in Kinofilmen z.B.: Zu Terminator-2-Zeiten war man sogar noch auf Making-Ofs scharf. Sowas kann heute jeder PC in Echtzeit zuhause, das reißt niemanden mehr vom Hocker. Deswegen sind wir CG-Technisch aber noch lange nicht abgestumpft, im Gegenteil, die Ansprüche sind gestiegen. (Heißt nicht, dass diese Erwartungen stets erfüllt werden)

Lieber dumm fragen, als dumm bleiben!

https://jonathank.de/games/

https://jonathank.de/games/

Re: Concept Art made by KI

Genau das. Ansprüche steigen. Im Fall der Filme, wo die Effekte praktisch längst ausgereizt sind (alles ist möglich, das "wie" ist keine Magie mehr), steigt der Anspruch an den Kontent u.a. Ästhetik, Inhalt, Logik, Schauspiel, Worldbuilding, Immersion, ... und das halte ich für eine gute Entwicklung. Natürlich gibts auch weiter viel Ramsch, je einfacher die Technik, desto mehr, das gabs immer. Aber das ist auch nicht der Punkt.

Letzte technische Film-Innovationen, die ich trotzdem noch beeindruckend fand: a) Stagecraft, b) Integration "alter" Schauspieler durch KI-Unterstützung (z.B. junger Luke, full body, beim Training, glaube in Mandalorian 2(?), eine ganz andere Nummer als die steifen 3D-Nachahmungen bisher)

Letzte technische Film-Innovationen, die ich trotzdem noch beeindruckend fand: a) Stagecraft, b) Integration "alter" Schauspieler durch KI-Unterstützung (z.B. junger Luke, full body, beim Training, glaube in Mandalorian 2(?), eine ganz andere Nummer als die steifen 3D-Nachahmungen bisher)

Re: Concept Art made by KI

BTT:

Ich habe den Thread ja vor etwas mehr als einem Jahr mit skurrilen Wombo-Baumhaus-Concepts angefangen. Heute mal das gleiche Thema draufgeschickt, wieder nur npr-Stile, diesmal allerdings Stable Diffusion auf dem eigenen Rechner. Ist schon ein kleiner Unterschied was man machen kann seit "damals" :D

20 Varianten mit verschiedenen Themen und Stilen, zusammengestellt 2560 x 3072 px

Dez. '21 Wombo vs. Jan. '23 Stable

Ich habe den Thread ja vor etwas mehr als einem Jahr mit skurrilen Wombo-Baumhaus-Concepts angefangen. Heute mal das gleiche Thema draufgeschickt, wieder nur npr-Stile, diesmal allerdings Stable Diffusion auf dem eigenen Rechner. Ist schon ein kleiner Unterschied was man machen kann seit "damals" :D

20 Varianten mit verschiedenen Themen und Stilen, zusammengestellt 2560 x 3072 px

Dez. '21 Wombo vs. Jan. '23 Stable

Re: Concept Art made by KI

Ja, daran musste ich auch denken, als der Thread hier wieder aktiv wurde. Damals hab ich die Bilder ja glaube ich recht scharf kritisiert, heute muss ich sagen, dass davon vieles einfach nicht mehr zutrifft. Also klar, man kann immernoch sehr oft sehr leicht Artefakte finden die einem echten Künstler so nie passiert wären, natürlich ist es noch nicht perfekt. Aber wenn man sich diese rasante Entwicklung anguckt, da fällt es selbst als Pessimist schwer darauf zu bestehen, dass das einfach nie vernünftig funktionieren wird...

Lieber dumm fragen, als dumm bleiben!

https://jonathank.de/games/

https://jonathank.de/games/

Re: Concept Art made by KI

Aktuell lote ich vor allem neue Workflows aus, die ich im Netz so aufschnappe.

Image-to-Image als Basis für konsistentere Char-Konzepte.

Praktisch wie oben mit den Assets. Nur: wenn man das mit einem geigneten KI-Modell und einer konsistenten Vorlage macht, hat man tatsächlich Chancen, dass ein einigermaßen konsistenter Turnaround herauskommt. Ein 3D-Grafiker namens Valentin Yovchev (SPYBG) hat freundlicherweise ein paar 3D-Templates seiner Arbeiten für genau diesen Zweck zur Verfügung gestellt.

Interessant wird es, ob man auf diese Art brauchbare Bilder produzieren kann, die sich für Textual Inversion eignen würden.

In- und Outpainting um Backdrops gezielt zu entwerfen und zu ändern.

Das klappt ganz gut. Leider gibt es noch keine Stiftunterstützung in Invoke, und Colorpicking, Pinselgröße, Deckkraft sind nicht so bequem zu erreichen als dass man wirklich fließend damit arbeiten könnte.

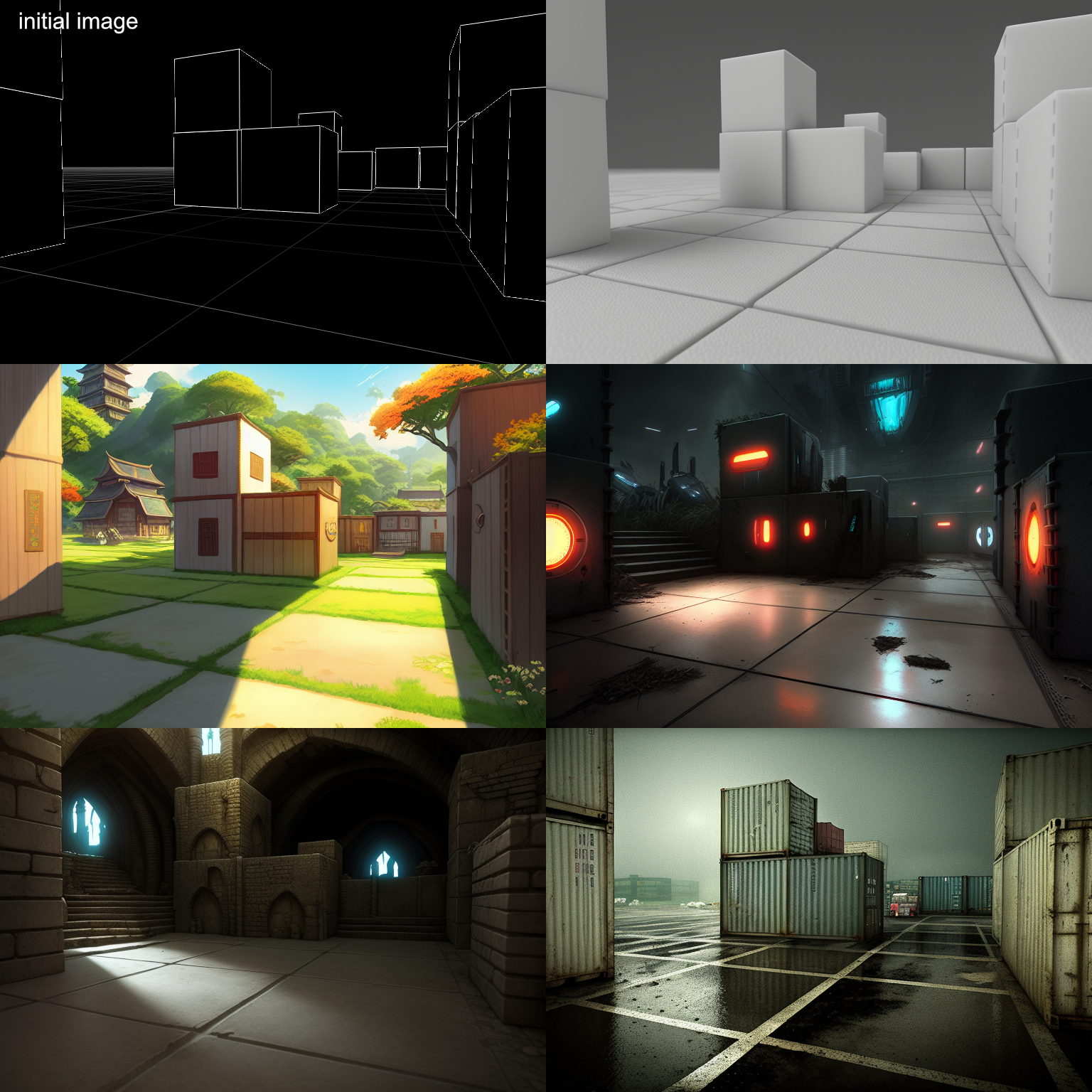

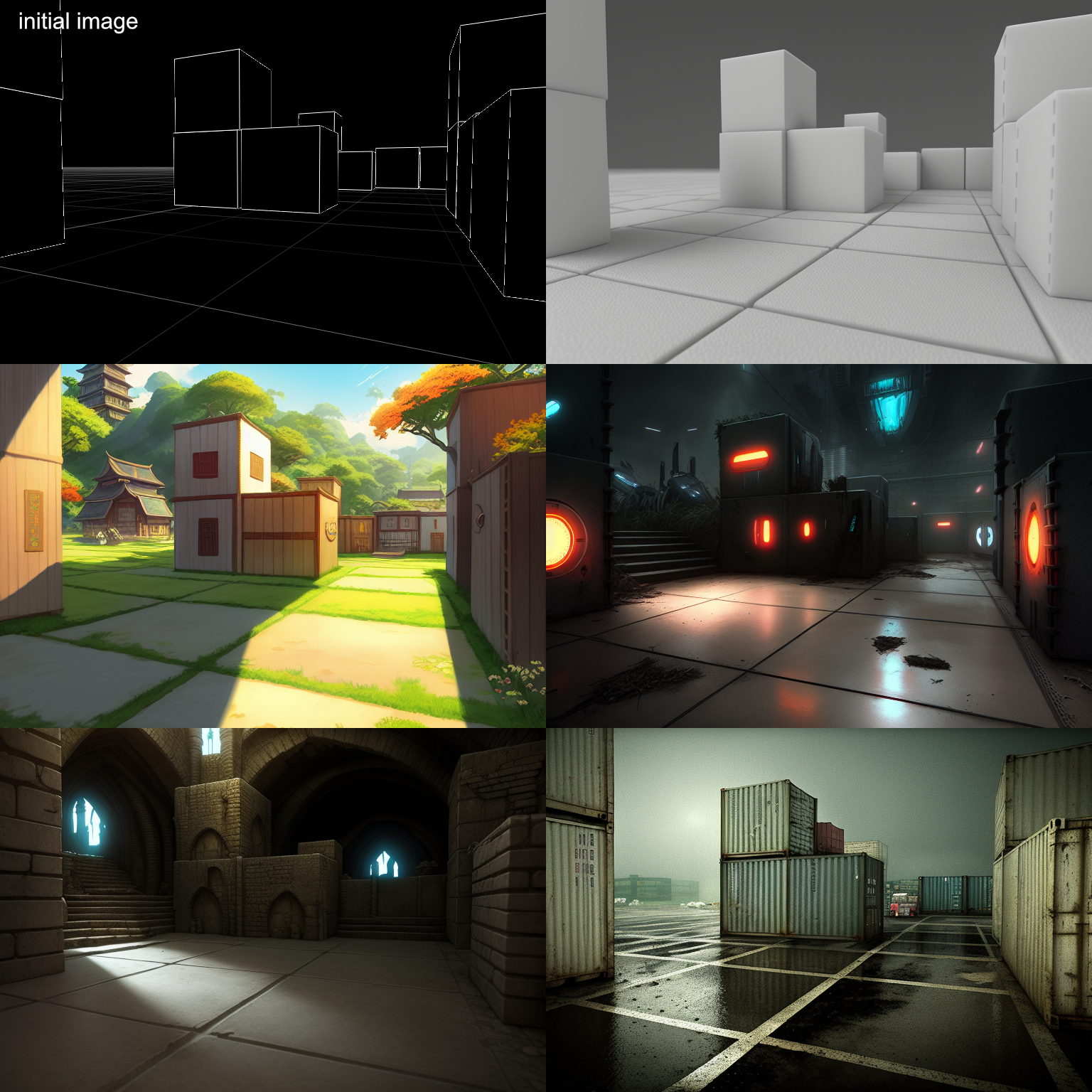

Depth-to-Image (hier via Blender-Plugin) für Projektionstexturen.

Vieles ist im Handling noch verbesserungswürdig. Habe da jetzt auch nicht so lange mit rumgespielt dass ich was wirklich Brauchbares zeigen könnte. Daher nur mal ne einfache Subdiv-Box mit ein paar Extrusions als "Gebäude".

Für Assets würde ich das aktuell nicht nehmen, aber für Konzeptgrafiken aus groben 3D-Skizzen ist das recht interessant, und evtl. kann man so auch konsistentere Environment-Entwürfe mit mehreren Views erstellen.

Image-to-Image als Basis für konsistentere Char-Konzepte.

Praktisch wie oben mit den Assets. Nur: wenn man das mit einem geigneten KI-Modell und einer konsistenten Vorlage macht, hat man tatsächlich Chancen, dass ein einigermaßen konsistenter Turnaround herauskommt. Ein 3D-Grafiker namens Valentin Yovchev (SPYBG) hat freundlicherweise ein paar 3D-Templates seiner Arbeiten für genau diesen Zweck zur Verfügung gestellt.

Interessant wird es, ob man auf diese Art brauchbare Bilder produzieren kann, die sich für Textual Inversion eignen würden.

In- und Outpainting um Backdrops gezielt zu entwerfen und zu ändern.

Das klappt ganz gut. Leider gibt es noch keine Stiftunterstützung in Invoke, und Colorpicking, Pinselgröße, Deckkraft sind nicht so bequem zu erreichen als dass man wirklich fließend damit arbeiten könnte.

Depth-to-Image (hier via Blender-Plugin) für Projektionstexturen.

Vieles ist im Handling noch verbesserungswürdig. Habe da jetzt auch nicht so lange mit rumgespielt dass ich was wirklich Brauchbares zeigen könnte. Daher nur mal ne einfache Subdiv-Box mit ein paar Extrusions als "Gebäude".

Für Assets würde ich das aktuell nicht nehmen, aber für Konzeptgrafiken aus groben 3D-Skizzen ist das recht interessant, und evtl. kann man so auch konsistentere Environment-Entwürfe mit mehreren Views erstellen.

Re: Concept Art made by KI

Feingetuntes Image-to-Image, gestartet mit einer händischen Skizze.

Re: Concept Art made by KI

Hier ein Zitat aus einem Bericht zum aktuellen Kino, der im Prinzip beschreibt, was ich gemeint habe. Geht hier speziell um Avatar 2, ob der Film dieses Lob verdient hat kann ich nicht sagen, ich poste das nicht wegen diesem Film, aber die prinzipielle Aussage meine ich. Und ich denke das trifft dann auch auf die KI-Schaffensflut in vielen Bereichen zu.joeydee hat geschrieben: ↑13.01.2023, 13:22 Im Fall der Filme, wo die Effekte praktisch längst ausgereizt sind (alles ist möglich, das "wie" ist keine Magie mehr), steigt der Anspruch an den Kontent u.a. Ästhetik, Inhalt, Logik, Schauspiel, Worldbuilding, Immersion, ... und das halte ich für eine gute Entwicklung. Natürlich gibts auch weiter viel Ramsch, je einfacher die Technik, desto mehr, das gabs immer.

https://www.moviepilot.de/news/nach-avatar-2-ist-es-fast-unmoeglich-nochmal-einen-marvel-film-zu-schauen-1139596 hat geschrieben:Das gegenwärtige Blockbuster-Kino spaltet sich auf visueller Ebene in zwei Lager. Auf der einen Seite stehen wenige erlesene Filme, die bewusst an ihrer Bildsprache feilen und oft mit einem großen Regienamen verbunden sind. Auf der anderen Seite ballt sich eine Masse an Blockbustern, die dem immergleichen, undefinierbaren Look hinterherjagen, obwohl sie alle so toll aussehen könnten wie The Way of Water.

Re: Concept Art made by KI

Finde die Kritik ein bisschen komisch. Also ich habe den Film noch nicht gesehen, weiß aber z.B. das Weta Digital über Jahre hinweg ihren Research auf Avatar 2 ausgerichtet haben, damit der halt absolut revolutionär wird. Die Unterwassereffekte in Alita: Battle Angle waren bsp. nur ein Nebenprodukt der Effekte die eh schon für Avatar entwickelt wurden. Die hätte es ohne Avatar so wohl nicht gegeben und umgekehrt hätte man Avatar wohl auch nicht finanzieren können, wenn man nicht die Zwischenprodukte schon vermarktet hätte. Und das ist wohl auch in einem halben dutzend anderer Filme ähnlich so passiert. Alles wegen Avatar 2.

Bei anderen Filmen hab ich es nicht so mitbekommen, deswegen ist meine Perspektive vlt. nicht ganz komplett, aber mir scheint, dass Avatar den Effekt-Research mehr vorangetrieben hat, als quasi die meisten anderen Filme seit Avatar 1 zusammen. Und dann zu sagen "Marvel Filme könnten auch so aussehen, wenn sie gewollt hätten" ist zumindest aus technischer Perspektive dann etwas albern. Das ist einfach eine ganz andere Dimension und das Projekt war auf etwas ganz anderes ausgelegt. Avatar wollte mit absurden Aufwand fantastisch aussehen und hat das wohl geschafft. Der Film selbst interessiert mich gar nicht mal so, aber das die Grafikresearch damit so pushen fand ich gut.

Bei anderen Filmen hab ich es nicht so mitbekommen, deswegen ist meine Perspektive vlt. nicht ganz komplett, aber mir scheint, dass Avatar den Effekt-Research mehr vorangetrieben hat, als quasi die meisten anderen Filme seit Avatar 1 zusammen. Und dann zu sagen "Marvel Filme könnten auch so aussehen, wenn sie gewollt hätten" ist zumindest aus technischer Perspektive dann etwas albern. Das ist einfach eine ganz andere Dimension und das Projekt war auf etwas ganz anderes ausgelegt. Avatar wollte mit absurden Aufwand fantastisch aussehen und hat das wohl geschafft. Der Film selbst interessiert mich gar nicht mal so, aber das die Grafikresearch damit so pushen fand ich gut.

Lieber dumm fragen, als dumm bleiben!

https://jonathank.de/games/

https://jonathank.de/games/

- Krishty

- Establishment

- Beiträge: 8316

- Registriert: 26.02.2009, 11:18

- Benutzertext: state is the enemy

- Kontaktdaten:

Re: Concept Art made by KI

BTW: Ich glaube, dass es im Film zwei (2) Szenen gab, die nicht komplett an Computer/Greenscreen entstanden sind. Jedenfalls fühlten die sich sehr merkwürdig an. Als würde man aus einem Traum erwachen, hätte kurz einen luziden Augenblick, und schliefe dann wieder ein.

Re: Concept Art made by KI

Ja, ne war klar wo hier reingehookt wird.

Ne, das habe ich nicht gemeint.

Kurz nochmal:

- Gute Computertricks kann inzwischen jeder, Marvel wie Weta wie andere.

- Durch verbesserte Technik allein hebt sich niemand mehr ab, die Blockbuster-Massenware wurde irgendwie zum schnell produzierten austauschbaren Einheitsbrei.

- So wie sich das evtl. mit KI-Kunst vor allem in der Konzept- und Coverbranche abbilden könnte.

- In beiden Fällen, so denke ich, wird sich die Spreu vom Weizen durch andere Qualitäten.

- So, wie sich offensichtlich der Autor dieses Artikels durch gewaltige Bildsprache beeindrucken ließ, die er, rein subjektiv, bei anderen Filmen vermisst.

Für mich war der Artikel nur Bestätigung für diese Art der Entwicklung: billiger&schneller -> Einheitsbrei -> andere Qualitäten werden verlangt. Er hätte auch über Nudeln schreiben können. Tut nichts zur Sache.

Ne, das habe ich nicht gemeint.

Kurz nochmal:

- Gute Computertricks kann inzwischen jeder, Marvel wie Weta wie andere.

- Durch verbesserte Technik allein hebt sich niemand mehr ab, die Blockbuster-Massenware wurde irgendwie zum schnell produzierten austauschbaren Einheitsbrei.

- So wie sich das evtl. mit KI-Kunst vor allem in der Konzept- und Coverbranche abbilden könnte.

- In beiden Fällen, so denke ich, wird sich die Spreu vom Weizen durch andere Qualitäten.

- So, wie sich offensichtlich der Autor dieses Artikels durch gewaltige Bildsprache beeindrucken ließ, die er, rein subjektiv, bei anderen Filmen vermisst.

Für mich war der Artikel nur Bestätigung für diese Art der Entwicklung: billiger&schneller -> Einheitsbrei -> andere Qualitäten werden verlangt. Er hätte auch über Nudeln schreiben können. Tut nichts zur Sache.

Re: Concept Art made by KI

Besser als das o.g. Depth-to-Image funktionieren aktuell (d.h. seit gestern) ein paar ControlNet-Modelle für/mit StableDiffusion. Ein paar davon basieren auf preprocessed Kantenerkennung von einem beliebigen Eingangsbild, dann wird ein neues Bild generiert welches dazu passt. Schön dabei: Es ist kein eigenes "durchtrainiertes" Modell, sondern kann mit anderen Custom-Modellen zusammengeschaltet, sprich mit jedem beliebigen Stil benutzt werden.

Paper: https://arxiv.org/abs/2302.05543

Folgendes geht natürlich auch: Preprocessing Kantenerkennung aus, und einfach die Kanten eines Wireframe-Modells hochladen (s. angefügten Screenshot). Und/oder händisch skizzieren, geht ebenso.

Für Concept Art also ziemlich gute Kontrolle über Geometrie und Kamera. Das kann man auch zusätzlich noch z.B. mit einem grob geblockten Farbkonzept füttern.

Das Endbild auf die 3D-Geometrie projizieren und Texturen grabben ist noch obligatorisch, dazu bin ich noch nicht gekommen, steht natürlich noch an. Mit passenden Prompts kann man ja das Lighting ziemlich neutral halten.

Und in ein paar Jahren dann wird so live gerendert? :)

Paper: https://arxiv.org/abs/2302.05543

Folgendes geht natürlich auch: Preprocessing Kantenerkennung aus, und einfach die Kanten eines Wireframe-Modells hochladen (s. angefügten Screenshot). Und/oder händisch skizzieren, geht ebenso.

Für Concept Art also ziemlich gute Kontrolle über Geometrie und Kamera. Das kann man auch zusätzlich noch z.B. mit einem grob geblockten Farbkonzept füttern.

Das Endbild auf die 3D-Geometrie projizieren und Texturen grabben ist noch obligatorisch, dazu bin ich noch nicht gekommen, steht natürlich noch an. Mit passenden Prompts kann man ja das Lighting ziemlich neutral halten.

Und in ein paar Jahren dann wird so live gerendert? :)

- Chromanoid

- Moderator

- Beiträge: 4275

- Registriert: 16.10.2002, 19:39

- Echter Name: Christian Kulenkampff

- Wohnort: Lüneburg

Re: Concept Art made by KI

Augmented Reality Headsets könnten dann auch ziemlich interessante Ergebnisse erzielen. Man gibt einfach an, welches Setting man haben will und schon kann das elektronisch gestützte LARP los gehen...

- Schrompf

- Moderator

- Beiträge: 5074

- Registriert: 25.02.2009, 23:44

- Benutzertext: Lernt nur selten dazu

- Echter Name: Thomas

- Wohnort: Dresden

- Kontaktdaten:

Re: Concept Art made by KI

Nee, das scheitert doch sofort. Diese Tools kriegen doch nichtmal zeit-konsistente Ergebnisse hin, geschweige denn dass Du was Spannendes in der AR entdeckst und drauf zugehst oder gar drumrum, um die Rückseite zu sehen. Ganz zu schweigen davon, was die anderen SpielerInnen stattdessen sehen. Sehen die das Gleiche? Ist das überhaupt deterministisch, was man da rausbekommt? Und wenn nein, warum nicht? Vielleicht kann man das ja mal abschalten, um als ersten Schritt SameInput -> SameOutput hinzukriegen.

Hihi. Ich seh dann schon, wie leute an ihren Query hinten noch nen Hash-Buchstabensalat als "Seed" dranhängen, und in Nullkommanix gibt's dafür Tool-Support, und nen Reddit, der die besten sammelt.

Hihi. Ich seh dann schon, wie leute an ihren Query hinten noch nen Hash-Buchstabensalat als "Seed" dranhängen, und in Nullkommanix gibt's dafür Tool-Support, und nen Reddit, der die besten sammelt.

Früher mal Dreamworlds. Früher mal Open Asset Import Library. Heutzutage nur noch so rumwursteln.

- Chromanoid

- Moderator

- Beiträge: 4275

- Registriert: 16.10.2002, 19:39

- Echter Name: Christian Kulenkampff

- Wohnort: Lüneburg

Re: Concept Art made by KI

Mit GPS, Vernetzung der Headsets und einem vorherigem Spaziergang durch das Gelände lässt sich das bestimmt lösen :) also zukünftig. Ist am Ende doch eine kontextuelle Retusche. Wenn in die Berechnung vorherige Bilder naheliegender Positionen und der richtigen Blickachse aller Beteiligten einfließen, kann ich mir schon vorstellen dass das klappt. An den ganzen Konsistenz-Problmen wird ja permanent gearbeitet. Ist ja auch für Videobearbeitung usw. total wichtig. Bei dem GTA Post-Processing ging das doch auch schon ganz ok.Schrompf hat geschrieben: ↑15.02.2023, 11:37 Nee, das scheitert doch sofort. Diese Tools kriegen doch nichtmal zeit-konsistente Ergebnisse hin, geschweige denn dass Du was Spannendes in der AR entdeckst und drauf zugehst oder gar drumrum, um die Rückseite zu sehen. Ganz zu schweigen davon, was die anderen SpielerInnen stattdessen sehen. Sehen die das Gleiche? Ist das überhaupt deterministisch, was man da rausbekommt? Und wenn nein, warum nicht? Vielleicht kann man das ja mal abschalten, um als ersten Schritt SameInput -> SameOutput hinzukriegen.

Re: Concept Art made by KI

Natürlich lässt sich das lösen. Ich selbst bin ja gerade an einer einfachen Lösung. Zwar mehr für statische 3D-Backgrounds und Char-Posing gedacht, nicht für ganze interaktive Level, aber die "Probleme" sind erstmal dieselben, und prinzipiell mit aktueller Technik lösbar, wenn auch nicht in Ectzeit on-the-fly.

Und ja, natürlich ist das komplett deterministisch, Computer können nur Pseudorandom. Von Anfang an war "Seed" neben "Prompt" nur einer von rund 3 Dutzend Parametern allein beim txt2img-Aufruf in Stable Diffusion. Gleiche Parameter - pixelgleiches Ergebnis. Tut nicht Not, dass User da einen "Hash" erfinden und an den Prompt hängen müssen ;)

Für zeitliche bzw. räumliche Konsistenz waren die Image-Tools natürlich nie gemacht. Da sie aber mit Abstand am "kreativsten" scheinen, möchte natürlich jetzt jeder lieber auf diesen -to-3D aufbauen, statt auf reines Text-to-3D. Es sind daher für 2D-to-3D eine handvoll niedriger- und höhergreifende Ansätze in den Pipelines, z.B. irgendwelche Geo-Morph-Maps welche sich um Depth-Estimated Geometrie legen, 3D-Scan-like-Ansätze welche aus einer handvoll (prinzipiell inkonsistenter) Bilder konsistentes 3D schaffen, Videofilter welche Bildfolgen angleichen, Depth-estimated masking mit Background-Outpainting um solche Facebook-Tiefenwackelbilder zu erstellen, Skybox-Generatoren, ... das alles ist erst ganz am Anfang, und erfordern eine ganze Reihe von Tools in der richtigen Reihenfolge mit den richtigen Einstellungen. Einige dieser Ansätze, richtig zusammengeschaltet und iterativ angewendet, könnten aber tatsächlich in der Lage sein, ganze konsistente Welten zu schaffen. Interaktivität wäre dann natürlich das nächste Thema ;)

Und ja, natürlich ist das komplett deterministisch, Computer können nur Pseudorandom. Von Anfang an war "Seed" neben "Prompt" nur einer von rund 3 Dutzend Parametern allein beim txt2img-Aufruf in Stable Diffusion. Gleiche Parameter - pixelgleiches Ergebnis. Tut nicht Not, dass User da einen "Hash" erfinden und an den Prompt hängen müssen ;)

Für zeitliche bzw. räumliche Konsistenz waren die Image-Tools natürlich nie gemacht. Da sie aber mit Abstand am "kreativsten" scheinen, möchte natürlich jetzt jeder lieber auf diesen -to-3D aufbauen, statt auf reines Text-to-3D. Es sind daher für 2D-to-3D eine handvoll niedriger- und höhergreifende Ansätze in den Pipelines, z.B. irgendwelche Geo-Morph-Maps welche sich um Depth-Estimated Geometrie legen, 3D-Scan-like-Ansätze welche aus einer handvoll (prinzipiell inkonsistenter) Bilder konsistentes 3D schaffen, Videofilter welche Bildfolgen angleichen, Depth-estimated masking mit Background-Outpainting um solche Facebook-Tiefenwackelbilder zu erstellen, Skybox-Generatoren, ... das alles ist erst ganz am Anfang, und erfordern eine ganze Reihe von Tools in der richtigen Reihenfolge mit den richtigen Einstellungen. Einige dieser Ansätze, richtig zusammengeschaltet und iterativ angewendet, könnten aber tatsächlich in der Lage sein, ganze konsistente Welten zu schaffen. Interaktivität wäre dann natürlich das nächste Thema ;)

Re: Concept Art made by KI

Nicht dass ich von vollautomatisiertem Tex-to-3D aktuell viel halte, aber hier z.B. zwei der vielen Ansätze/Experimente:

https://dreamfusion3d.github.io/

https://lukashoel.github.io/text-to-room/

Meine Vermutung scheint richtig, dass irgendwie imagebased der (aus Designsicht) interessantere Ansatz ist statt direkt auf 3D-Daten zu trainieren, und dass das mit NeRF-Technik verschmilzt.

Allerdings habe ich KI-Tools lieber als Kreativ-Support, statt einen vollautomatischen Full-Content-Creator.

https://dreamfusion3d.github.io/

https://lukashoel.github.io/text-to-room/

Meine Vermutung scheint richtig, dass irgendwie imagebased der (aus Designsicht) interessantere Ansatz ist statt direkt auf 3D-Daten zu trainieren, und dass das mit NeRF-Technik verschmilzt.

Allerdings habe ich KI-Tools lieber als Kreativ-Support, statt einen vollautomatischen Full-Content-Creator.

Re: Concept Art made by KI

Kehrseite der Medaille, muss natürlich auch immer gesehen werden. Ich poste es aber nicht nur deshalb, sondern auch, weil der Bericht mal einen konkreten Einblick in die Klein-Gameindustrie gibt, welchen Impact KI schon jetzt dort haben kann.

"I lost everything that made me love my job through Midjourney over night."

https://www.reddit.com/r/blender/commen ... ve_my_job/

Kurz: Er hatte bisher 3D-Assets für 2D-Games (also für gerenderte Sprites) gemacht, inzwischen promptet und photoshoppt er nur noch, was nicht mehr sein Traumjob ist, und auch sein bisheriger Skillvorsprung gegenüber seinem Kollegen ist nicht mehr vorhanden, und er schämt sich "gestohlene" Kunst zu verwenden, obwohl er eigenes Talent hätte. Allerdings ist der neue Workflow für ihre Zwecke schneller, günstiger, und qualitativ besser (sagt er selbst).

Aber wenn ich aufzähle was sich auch in meinem Job in den letzten 30 Jahren geändert hat - ich habe z.B. gelernt Layouts am Leuchttisch mit Skalpell und Kleber zusammenzubasteln und davon Abzüge in der Dunkelkammer zu machen. Kaum auszudenken, wenn der Umgang mit Skalpell, Film und Chemie mein Traum, und Tastaturen mein Alptraum gewesen wären. Für einen Kollegen war es damals aber genau das. Auch jetzt ändern sich gerade Dinge, die ich seit gut 15 Jahren mache (hat nichts mit KI zu tun). Spezialisieren ja, aber man muss auch flexibel bleiben, das gilt nunmal überall.

"I lost everything that made me love my job through Midjourney over night."

https://www.reddit.com/r/blender/commen ... ve_my_job/

Kurz: Er hatte bisher 3D-Assets für 2D-Games (also für gerenderte Sprites) gemacht, inzwischen promptet und photoshoppt er nur noch, was nicht mehr sein Traumjob ist, und auch sein bisheriger Skillvorsprung gegenüber seinem Kollegen ist nicht mehr vorhanden, und er schämt sich "gestohlene" Kunst zu verwenden, obwohl er eigenes Talent hätte. Allerdings ist der neue Workflow für ihre Zwecke schneller, günstiger, und qualitativ besser (sagt er selbst).

Aber wenn ich aufzähle was sich auch in meinem Job in den letzten 30 Jahren geändert hat - ich habe z.B. gelernt Layouts am Leuchttisch mit Skalpell und Kleber zusammenzubasteln und davon Abzüge in der Dunkelkammer zu machen. Kaum auszudenken, wenn der Umgang mit Skalpell, Film und Chemie mein Traum, und Tastaturen mein Alptraum gewesen wären. Für einen Kollegen war es damals aber genau das. Auch jetzt ändern sich gerade Dinge, die ich seit gut 15 Jahren mache (hat nichts mit KI zu tun). Spezialisieren ja, aber man muss auch flexibel bleiben, das gilt nunmal überall.

- Chromanoid

- Moderator

- Beiträge: 4275

- Registriert: 16.10.2002, 19:39

- Echter Name: Christian Kulenkampff

- Wohnort: Lüneburg

Re: Concept Art made by KI

Huhu, interessantes Update von Valve, falls ihr das noch nicht gesehen habt: https://www.reddit.com/r/aigamedev/comm ... s_with_ai/

Valve lehnt scheinbar Spiele mit AI generierten Inhalten ab. Wie sie die ermitteln, habe ich noch nicht verstanden.

[via The GameDiscoverCo newsletter]

Valve lehnt scheinbar Spiele mit AI generierten Inhalten ab. Wie sie die ermitteln, habe ich noch nicht verstanden.

[via The GameDiscoverCo newsletter]

Re: Concept Art made by KI

Ja, wurde aber wohl schon wieder relativiert: https://www.theverge.com/2023/7/1/23781 ... g-pc-games

- woodsmoke

- Establishment

- Beiträge: 102

- Registriert: 30.06.2023, 14:05

- Wohnort: Ludwigshafen

- Kontaktdaten:

Re: Concept Art made by KI

Wir dachten AI wird uns die Arbeit abnehmen und wir können uns der Kunst widmen.

Jetzt vergnügt sich AI damit Bilder und Musik zu machen und wir müssen immer noch arbeiten.

XD

Jetzt vergnügt sich AI damit Bilder und Musik zu machen und wir müssen immer noch arbeiten.

XD

Spiele: https://woodsmoke.itch.io/

Videos: https://www.youtube.com/@w00dsm0ke/

Zeichnungen: https://www.deviantart.com/melerski/gallery/all

Videos: https://www.youtube.com/@w00dsm0ke/

Zeichnungen: https://www.deviantart.com/melerski/gallery/all

Re: Concept Art made by KI

Aus dem Bereich "Artgerechte Haltung von Stable Diffusion als eigenes Haustier":

ComfyUI angetestet. Man sollte sich zwar ein wenig mit den KI-Begriffen von SD auskennen (latent image, VAE, checkpoint, ...), aber es gibt auch viele Beispiele.

Macht bisher weniger Probleme als Automatic1111, dabei auch noch schneller, unterstützt aktuelle Features (soweit ich sehen konnte), scheint also eine solide Sache zu sein. Auch das aktuelle SDXL-Modell z.B. läuft mit Comfy.

Hier z.B. ein Kombi-Workflow, bei dem zuerst eine allgemeine gemütliche Stadt-Postkartenansicht mit einem Custom-SD-Modell in Low-Res generiert wird, dann Upscale auf 1440x768, und schließlich mit anderem SD-Modell in Kombi mit einem LoRA-Tuning und neuen Prompts in Richtung handgezeichnetem Fantasy-Steampunk "gedrückt" wird (hier alles noch mit "alten" SD1.5er-Modellen). Zeit bis zum fertigen Bild: 17 Sek. auf einer TI3060.

Seit wenigen Tagen gibts übrigens auch eine neue Invoke-Version (ebenfalls ein Web-UI), noch nicht ausprobiert, aber das alte Invoke war auch sehr bequem, bislang eins der besten UIs, und es soll jetzt ebenfalls einen Node-Editor haben sowie ControlNet unterstützen.

ComfyUI angetestet. Man sollte sich zwar ein wenig mit den KI-Begriffen von SD auskennen (latent image, VAE, checkpoint, ...), aber es gibt auch viele Beispiele.

Macht bisher weniger Probleme als Automatic1111, dabei auch noch schneller, unterstützt aktuelle Features (soweit ich sehen konnte), scheint also eine solide Sache zu sein. Auch das aktuelle SDXL-Modell z.B. läuft mit Comfy.

Hier z.B. ein Kombi-Workflow, bei dem zuerst eine allgemeine gemütliche Stadt-Postkartenansicht mit einem Custom-SD-Modell in Low-Res generiert wird, dann Upscale auf 1440x768, und schließlich mit anderem SD-Modell in Kombi mit einem LoRA-Tuning und neuen Prompts in Richtung handgezeichnetem Fantasy-Steampunk "gedrückt" wird (hier alles noch mit "alten" SD1.5er-Modellen). Zeit bis zum fertigen Bild: 17 Sek. auf einer TI3060.

Seit wenigen Tagen gibts übrigens auch eine neue Invoke-Version (ebenfalls ein Web-UI), noch nicht ausprobiert, aber das alte Invoke war auch sehr bequem, bislang eins der besten UIs, und es soll jetzt ebenfalls einen Node-Editor haben sowie ControlNet unterstützen.